最小二乘估计量

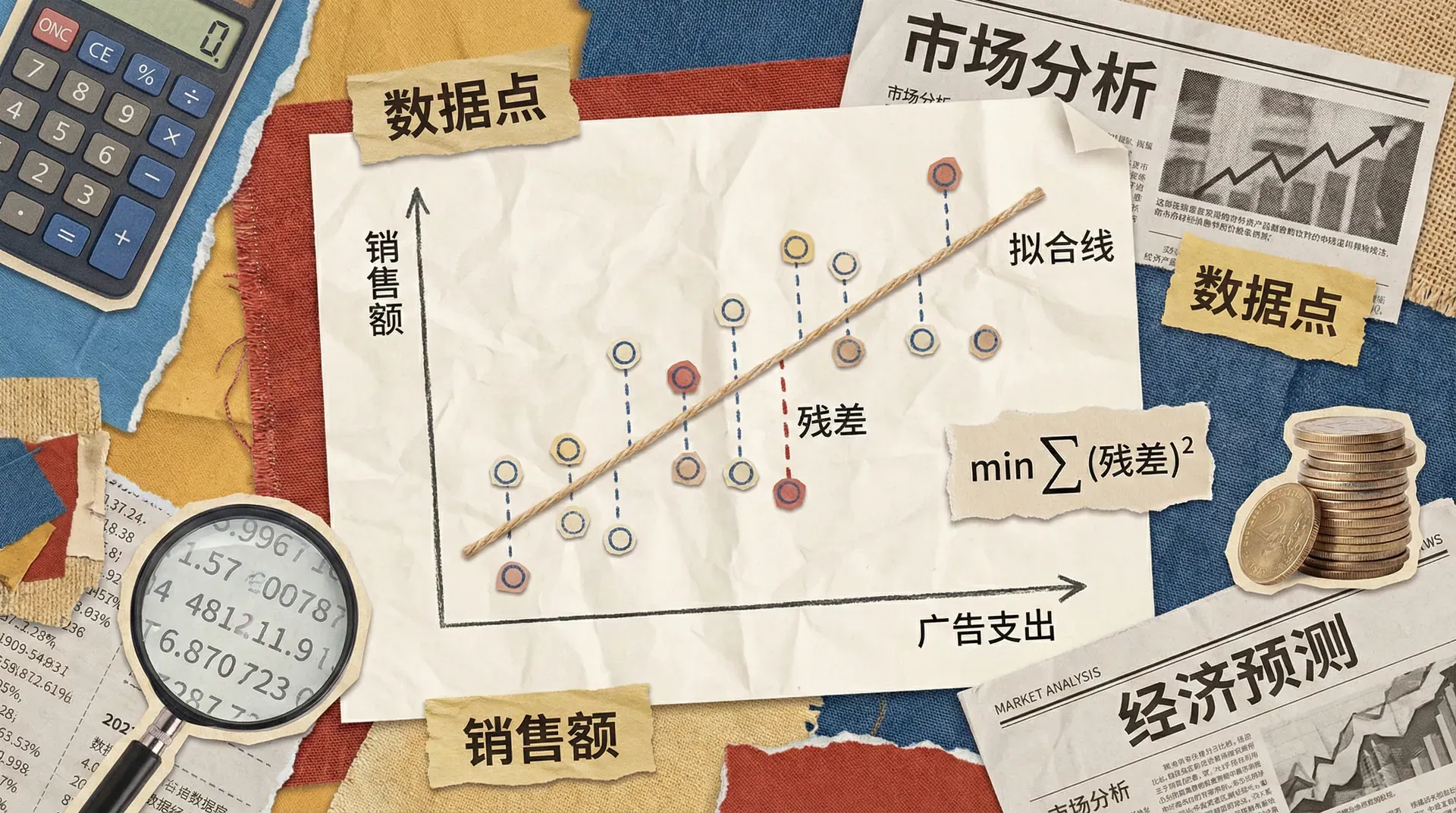

在前面的学习中,我们将最小二乘法视为一种纯粹的代数工具,用于在数据点中拟合一条最佳直线。现在,我们要将视角提升到更高的层次,将最小二乘法理解为线性回归模型参数的估计量。这个转变标志着我们从简单的曲线拟合进入了真正的统计推断领域。

如果你是一位经济学家,正在研究中国城市居民的消费行为,你手中有一份包含1000个家庭收入和支出数据的样本。这些数据不仅仅是散点图上的点,它们代表着更大总体的一个缩影。你的目标不仅是描述这1000个家庭的消费模式,更重要的是要推断整个城市居民群体的消费规律。

最小二乘估计量的核心价值在于:它不仅能够拟合样本数据,更能够从有限的样本信息中推断出总体的真实参数,为经济政策制定提供科学依据。

本内容将探讨最小二乘估计量的统计性质,包括它在有限样本和大样本情况下的表现,以及如何利用这些性质进行区间估计和预测。我们将看到,在满足特定假设条件下,最小二乘估计量具有许多优良的统计性质,使其成为经济学研究中最重要的工具之一。

为什么选择最小二乘法

在众多可能的参数估计方法中,为什么最小二乘法(OLS)能够脱颖而出,成为经济学家和数据分析师的首选?其原因不仅在于计算的简便性,更由于深厚的理论基础以及在实际应用中的优良性能。

计算的便利性

最小二乘法最直观、最实际的优势在于计算简便且高效。在早期没有计算机的年代,经济学家必须手算复杂的数据统计量。OLS 提供了**封闭形式(closed form)**解,无需迭代:

这里, 是解释变量矩阵, 是因变量向量, 是参数估计值。这个公式可直接推算出全部回归系数。即使在今天面对大数据集(如),OLS 的计算速度和资源优越性也依然突出,不容易被更为复杂的方法超越。许多现代机器学习或统计方法,最后也依赖于线性回归的高效计算子程序。

总体正交性条件

最小二乘法的理论根基非常深刻。从总体出发,回归模型假设:

即误差项与解释变量无条件线性无关。进一步,推导为

这就是总体的正规方程(normal equation)。而在样本中,我们建立的正规方程:

即用样本协方差模拟总体协方差,寻找使样本协方差为零的系数 。因此OLS 不只是数据拟合的机械工具,更是“样本正交性”对理论条件的具体实现和近似。

最小二乘法的本质,是以样本模拟总体正交性条件。它不仅是拟合曲线,更是连接经济理论和统计学推断的桥梁。

最优线性预测器

即便我们不要求所有经典假设成立,OLS 仍然有其独特的稳健性。如果我们要在线性预测器 的全体中,找到均方误差最小者:

其一阶条件(通过对求导设置为零)正好得出:

因此,无论是否真正线性,OLS 估计给出的是所有线性函数中的最佳近似,这一“最优线性预测性”解释了线性回归在实际建模中的广范适用性。

这表明:即使现实中 不线性,OLS 也给出均方意义下最优的线性近似。这种稳健性让最小二乘法在各种实际应用下仍然极具竞争力。

最小方差线性无偏估计

如果所有经典线性回归假设都满足,最小二乘估计量还具有一个极优性质:它是在所有线性、无偏估计量中,方差最小的。这由著名的高斯-马尔科夫定理(Gauss-Markov theorem)保障,因此称OLS为“最佳线性无偏估计(BLUE)”。我们将在后文详细推导和讨论其证明,为后续标准误差、置信区间与假设检验打基础。

经典线性回归模型的假设

为了支撑上述各种理论性质,我们需明确经典线性回归模型的六大假设。这些是后续推论和统计推断的出发点。

模型假设总览

假设的现实意义

借助实际例子,帮助深化理解。例如,研究中国制造业的生产函数:

- A1(线性): 与各投入的存在线性关系。这在柯布-道格拉斯生产函数做对数变换后天然成立。

- A2(满秩):要求、、技术水平特征之间不能完全线性相关,否则参数无法唯一确定。

- A3(外生性):关键、最难满足。若遗漏变量(如管理水平)既影响又与相关,则预测有偏。

假设违反的后果

一旦前述假设被违反,最小二乘估计量的性质也会发生变化。通常分三类核心影响:

- 违反外生性(A3):,导致估计量有偏且不一致(biased and inconsistent),这是最为严重和必须警惕的问题(例如遗漏变量、内生性)。

- 违反球形误差(A4):,OLS估计量仍然无偏,但不再是最有效的,标准误差估计不准确,区间与显著性检验会失真。

在实际数据分析中,上述假设很难全部满足。应对策略是发展更稳健的估计方法(例如广义最小二乘、工具变量等)、诊断与修正程序,保证结果的有效性与解释力。

这些经典假设为我们提供了理想化的分析框架,使我们能够推导并理解OLS的统计性质。后续章节将以此为基础,深入剖析线性回归估计量的表现、推断与稳健性。

最小二乘估计量的有限样本性质

有限样本性质是指无论样本大小如何,OLS估计量都具有的统计特征。这些性质在任何有限样本规模下都成立,为最小二乘法在科学和实际应用中的可靠性提供了坚实的理论基础。

无偏性

最小二乘估计量\MV在有限样本下最重要的性质之一是无偏性。这意味着即使一次抽样计算的参数估计值可能与真实值有偏差,但如果我们能够重复进行抽样,所有估计值的平均值就等于真实参数。

数学表达:

也就是说, 作为 的估计量,在条件于解释变量 的情况下,没有系统性高估或低估的趋势。

假设我们感兴趣的是教育收益率,真实的教育回报率为8%(即每增加一年教育,工资平均提升)。我们可从总体中不断抽样,分别计算估计值。每个样本对应一个估计值。

如图,每个单独样本给出的估计值可能大于或小于,但所有样本平均值等于真实参数(),这就是无偏性直观体现。

无偏性的证明思路

我们来看看最小二乘估计量为什么在有限样本下无偏。证明步骤如下:

-

写出OLS估计量的代数表达式

因此,最小二乘估计量的条件期望等于真实参数,无论样本规模如何都成立。

无偏性说明在理论上重复抽样时,最小二乘法不会系统性地高估或低估真实参数。在实证经济学和科学研究中,这是OLS最核心的优良特性之一。

遗漏变量偏差

在实际研究中,我们经常无法观测所有影响因子。例如模型理论要求我们考虑某些解释变量,但现实中无法获取相关数据。此时,我们“遗漏”了重要变量,最小二乘估计量会产生遗漏变量偏差(omitted variable bias)。

假设真实模型为:

但我们只能估计简化模型:

此时,,解释变量被遗漏进误差项,由此OLS估计量的期望为:

其中,

即是把对回归之后得到的相关系数矩阵。只要与相关,,就会产生系统性偏差。

房价与遗漏变量

以中国房价的决定因素为例,真实模型写作:

假设因为数据限制,我们估计的是简化模型:

如果面积与地段/学区质量正相关(大房子更可能处于好地段/好学区),则对面积系数的OLS估计会高于真实值,因为遗漏因素的影响混入面积估计中。

遗漏变量偏差在实证经济学、社会科学等领域极其常见且严重。必须在模型设定时尽量考虑所有关键变量,或通过工具变量法等策略矫正相关偏差。

包含无关变量的影响

与遗漏重要变量不同,**多包含无关变量(超变量)**的后果要温和得多。如果在真实模型基础上添加无关解释变量:

假设真实模型:

实际估计时,增加了无用的变量:

且。此时:

- 估计量仍然无偏: ,

直观讲,这就像用大炮打蚊子——“能打中”,但估计精度下降。

高斯-马尔科夫定理(最小方差无偏性)

在经典回归假设(线性、同方差、无自相关等)成立下,OLS估计量不仅无偏,而且在所有线性无偏估计量中方差最小。这就是著名的高斯-马尔科夫定理。

定理表述:

定理的经济学意义

高斯-马尔科夫定理说明:在所有“线性+无偏”方法中,OLS给出最精确的估计。 这条理论结果是OLS广泛应用于经济学和自然科学研究的理论基础。

下面通过可视化对比加深理解:

如图,OLS估计量的方差明显小于其他线性无偏估计量的方差,最小二乘法更为高效。

估计量方差的推导和含义

在所有经典回归假设下,最小二乘估计量的方差可以准确表示为:

这个公式揭示了以下几个重要经济直觉:

- 样本规模:随着增多,中的元素变大,整体变小,的方差降低,估计更精确。

方差的实际估算及应用

实际工作中,未知,通常通过残差计算样本误差方差:

其中,为残差向量,是样本量,为参数数目。

进而,的样本方差估计为:

有了方差的估计,就能进一步计算标准误、假设检验和置信区间,这实现了从点估计到统计推断的关键飞跃。掌握这些性质,是经济计量建模和实证分析的重要基础。

大样本性质

有限样本的性质为我们搭建了坚实的理论基础,但在真实数据分析中,很多严格的假设(特别是关于误差的正态性假设)并不总能满足。这时,大样本理论(渐近理论)尤为重要,它允许我们在更宽松的条件下进行估计与推断。

一致性

一致性(Consistency)比无偏性更为基本。它告诉我们,随着样本量,估计量会收敛于真实参数值。也就是说,估计量对于“大数据”来说是可靠的。

具体而言,设为估计量,为真实参数,那么一致性可表示为:

这意味着当样本量很大时,偏离的概率趋近于零。

平均储蓄率估计的一致性直观展示

例如,我们要估计中国城镇居民的平均储蓄率。随着样本量从100到10000,从0.28逐渐收敛到真实值0.25:

如上图,随着样本量增加,的估计值逐渐接近。

一致性的条件

最小二乘估计量一致性成立需满足下列“渐近”条件:

-

数据矩阵的渐近行为:

与有限样本需要严格的同方差、独立同分布、正态等假设不同,上述条件宽松得多,所以一致性在实际应用中更容易满足。

渐近正态性

大样本下,受中心极限定理保证,最小二乘估计量即使误差不服从正态分布,也近似正态分布。其数学表达为:

等价于:

渐近正态性的实际意义

渐近正态性使得在误差非正态的情况下依然可以采用t检验、置信区间等推断方法。这极大扩展了最小二乘法的适用场景。

若误差服从偏态分布,样本量小时时,分布可能偏离正态分布,但样本量增加后,估计量的分布逐渐趋向标准正态:

如上图,越大,估计分布越接近标准正态分布。

Delta方法:非线性函数的渐近推断

实际中经常关心参数的某种函数(如弹性、乘数),而不是本身。Delta方法给出大样本下的近似分布:

其中:

- ,即梯度向量。

消费函数中的长期边际消费倾向

考虑中国消费行为的回归:

- :当期消费,:当期收入,:上期消费。

- 短期边际消费倾向为,长期为。

假设回归结果:

- ,标准误

- ,标准误

则,

梯度:

标准误差为:

95%置信区间:

Delta方法极大扩展了计量经济推断的应用范围,使我们能够对如弹性、乘数等非线性经济量进行置信区间估计与假设检验。

渐近效率

大样本下,最小二乘估计量具备渐近效率性:在误差正态的条件下,是所有线性无偏估计量中方差最小的(其实也是最大似然估计)。

但如果误差不服从正态分布,最小二乘法可能不是最优,这时可考虑最小绝对偏差(LAD)等更稳健的方法。

最小二乘法与LAD估计比较

当误差厚尾、含异常值时,LAD表现可能优于OLS。但在样本量大、误差分布不错时,OLS仍是主流首选。

一致性与无偏性的关系与区别

一致性和无偏性不是一回事。无偏性指,即平均不偏离;一致性指样本量趋于无穷时必定“粘住”。

下图形象示意三类情形:

- 红线:无偏但不一致——,但波动很大,随着不收敛

- 橙线:有偏但一致——小样本有偏,但时收敛到

- 绿线:无偏且一致——既平均正确也最终收敛到真值

在实际计量分析中,我们通常关注一致性多于无偏性。因为只要估计量是一致的,哪怕小样本有偏,随着大样本数据的积累,最终也能获得可靠的推断。

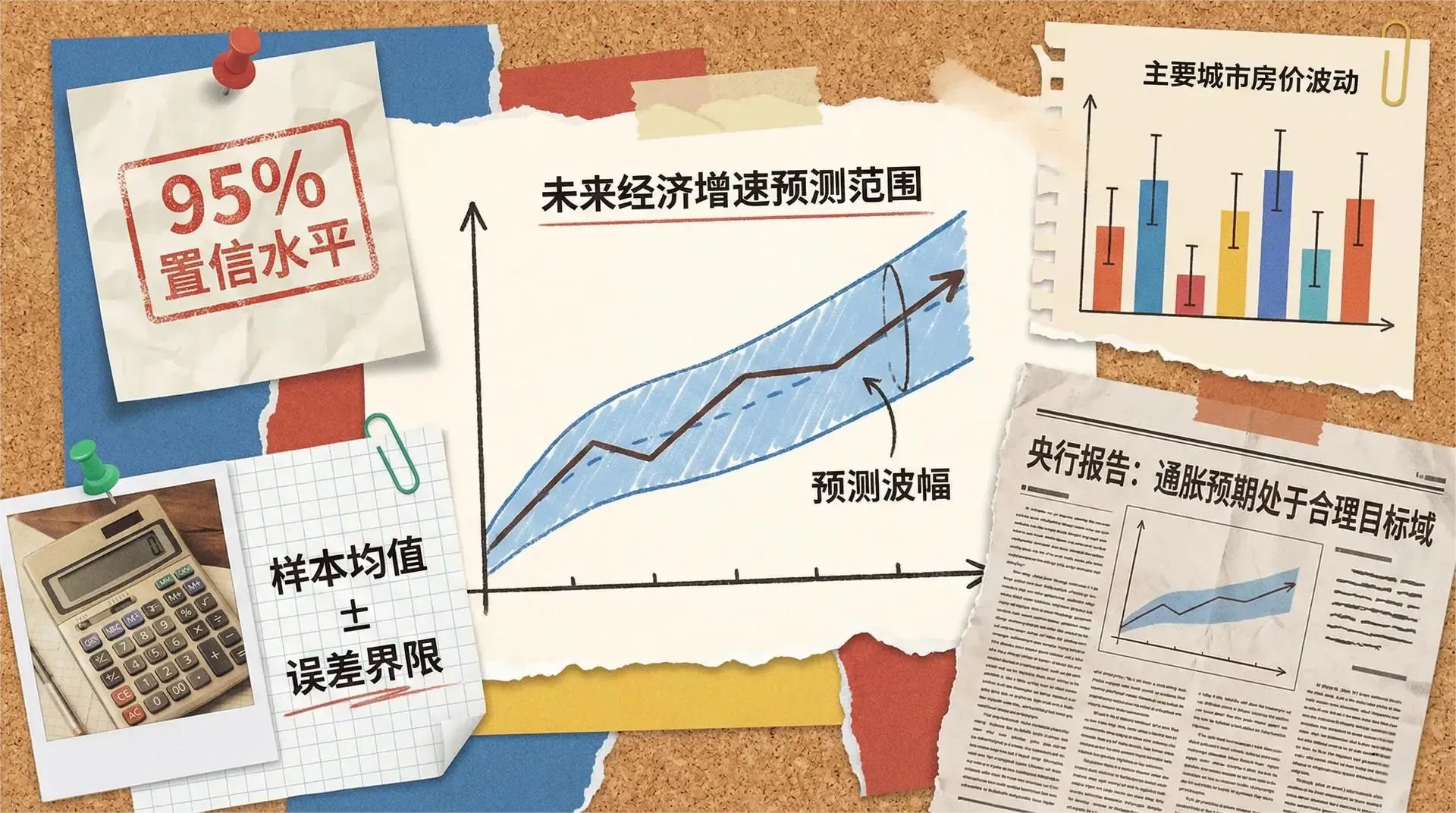

区间估计

点估计(point estimate)仅仅为我们提供了参数的单一估计值,无法反映其可靠性。而区间估计(interval estimate)通过构造置信区间来量化估计中的统计不确定性,从而为科学决策与政策制定提供更丰富的信息依据。

置信区间的基本思想

置信区间的核心思想是:我们虽然无法直接获得真实参数的精确数值,但可以依据样本数据,构造一个统计区间,使得该区间在预定概率(如95%)下包含真实参数值。例如:

其中和分别为置信区间的下限和上限。对于回归系数,95%置信区间的标准计算公式为:

其中:

- 为参数的点估计

- 为的标准误差

这种区间估计方式常用于回归分析、参数推断等经济计量应用场景。

中国教育收益率的置信区间

例如,某项针对中国人群的教育收益率回归分析,得到回归输出如下:

- 教育收益率估计值:

- 标准误差:

- 样本量:

- 自由度:

则置信区间计算为:

- 查表得 (大样本下近似为标准正态分布的)

- 置信区间:

也就是说,我们有的把握认为,中国的真实教育收益率落在之间。这使得分析者不仅知道"最可能"的点估计,也能具体了解"不确定性"大致在哪个范围内。

置信区间的正确解释

置信区间概念往往容易被误解,下面很重要:

错误解释: 真实参数有的概率落在置信区间内。

正确解释: 如果我们反复抽样并每次构造置信区间,那么这些区间中大约有会包含真实参数值。

请注意,真实参数是一个确定但未知的常数;置信区间是基于抽样计算出来的随机变量。因此,区间本身是随机的,参数是固定的。

影响置信区间宽度的因素

置信区间的宽窄(即区间长度)受多个关键因素影响:

具体来讲,置信区间的长度能够用公式刻画:

这其中,本身与、、矩阵结构强相关。

大样本置信区间

当样本量较大(通常),分布的临界值与标准正态分布的临界值非常接近。此时可直接采用来简化95%置信区间的计算,即:

这在实际应用中极为常见,既方便又不失精度。

预测与预测区间

回归模型除了用于参数估计,更在实际中被广泛用于预测新观测的因变量。通过已有样本建立模型后,我们可以基于新数据进行科学预测,并衡量预测的不确定性。

点预测

给定新的自变量取值,最小二乘回归对因变量的点预测为

其中是通过样本数据估计得到的回归系数向量。这一公式反映了最小二乘法在预测中的直接应用。

预测误差的来源

实际预测中,与真实的新观测之间存在误差。预测误差来源于两个方面:

- 参数估计误差:我们使用的是估计值,而非未知的真实参数。

- 随机扰动误差:新观测本身具有不可观测的扰动项。

因此,总的预测误差表达为

由此可见,预测误差不仅取决于模型估计的准确性,还取决于具体观测的偶然波动。

预测方差

对于给定的样本矩阵和新自变量,预测误差的方差(条件方差)可写作:

推导说明:

- 项:表示即使已知参数,未来观测的噪声仍带来基本不确定性;

- 项:反映我们用估计量代替真实参数而带来的额外估计误差;

这个公式传递了几个要点:

- 任何预测都有不可避免的不确定性,哪怕模型完全正确。

- 新观测离原始样本中心越远,越大,不确定性也越大。这体现了“外推预测”风险。

中国房价预测案例

设我们根据北京楼盘数据建立如下房价预测模型:

现用此模型预测一套平米、距地铁米房子的售价。

通过图形直观分析可以看到:

- 点预测:万元

- 95%预测区间:

- 预测区间在样本中心(如120平米)附近最窄,远离样本均值时,区间变宽反映风险增大

预测区间一般通过如下公式计算:

对数模型的预测问题

如果模型为对数线性形式,例如

要从预测实际,不能直接使用,因为

根据Jensen不等式,正确做法是

在应用中,由于未知,我们可以利用Duan提出的“涂抹估计量”修正偏差:

其中为残差。

对数模型的预测提醒:模型的函数形式影响最终预测,尤其在重还原到原始尺度时(如到水平变量)。所以在选择模型和解释结果时,务必考虑这一点。

预测精度的评估

衡量模型预测能力时,研究者会采用多种指标,包括:

此外,还可通过R方、预测区间覆盖率等指标补充评价。

样本外预测

对模型预测能力最严格的检验,是样本外预测(out-of-sample prediction)。典型流程:

- 数据分割:将样本划分为训练集(用于估计模型)和测试集(用于评估预测)。

- 模型估计:在训练集上拟合模型,得到系数估计。

- 预测与评价:对测试集(未参与建模的数据)做预测,计算RMSE、MAE等指标。

这种方法能有效反映模型在未来数据上的实际预测能力,是现代计量经济学与机器学习中的标准做法。相比样本内评价,样本外预测更能揭示模型的泛化能力和稳健性。

补充说明:预测区间(阈值)通常要比参数置信区间更宽,因为它综合考虑了参数估计的误差和新观测的不确定性。研究者应理解两者的差异,在报告预测区间时需注明计算依据、所用置信度等信息。

核心要点总结

理论框架的完整性

我们已经建立了最小二乘估计量的完整理论框架:

实际应用的指导原则

在实际应用最小二乘法和进行计量分析时,需要关注若干关键问题。

-

使用最小二乘法前建议严格检验各项基本假设的成立情况,只有在合理假设基础上,估计结果才具有理论解释意义。

-

样本量的大小会直接影响推断方法的选择:小样本情况下依靠正态性假设进行推断,大样本则可以利用渐近理论获得更稳健的结论。

-

模型设定需非常谨慎,因为遗漏重要变量往往会导致严重偏差,影响结论的有效性。在报告参数估计结果时,应始终给出标准误和置信区间,以便全面展现结果的不确定性。

-

模型预测能力并非铁板一块,预测的精度会随着所预测点距离样本区间中心越来越远而下降,因此实际解读和应用时要考虑预测的局限性。

最小二乘估计量不仅是一个数学工具,更是连接经济理论与实证数据的桥梁。它的统计性质为我们提供了科学推断的基础,使经济学研究能够超越定性分析,走向定量化和精确化。